KI-Fotos sind in der Art Direction inzwischen sehr beliebt, lassen sich aber nur begrenzt gestalten. Wir zeigen die Technik, mit der man konkrete Posen und Szenenbilder für Fotos von einer Künstlichen Intelligenz festlegen kann.

KI-Bilder sind günstig, einfach zu erstellen und qualitativ oft erstaunlich hochwertig. Dennoch haben sie im Vergleich zu echten Fotos einen Nachteil: Man kann Raumgestaltungen und Posen nicht so konkret festlegen, wie man es von der Arbeit mit Models gewohnt ist. Eine Spezialtechnik hilft in diesem Fall weiter.

ControlNet gibt der KI Informationen über Körperhaltung und Objekte

Um der KI konkrete Posen oder die Gestaltung von Räumen zu zeigen, nutzen wir ControlNet. ControlNet beschreibt sich selbst als Neurales Netzwerk, das KI-Modelle mit zusätzlichen Bedingungen kontrollieren kann – genau das, was wir brauchen, denn die Körperhaltung oder die Gestaltung von Szenen ist eine dieser zusätzlichen Bedingungen, die wir über einen Prompt nicht bis ins Detail umsetzen können.

Für ControlNet gibt es verschiedene Optionen, von denen wir zwei hier konkret vorstellen.

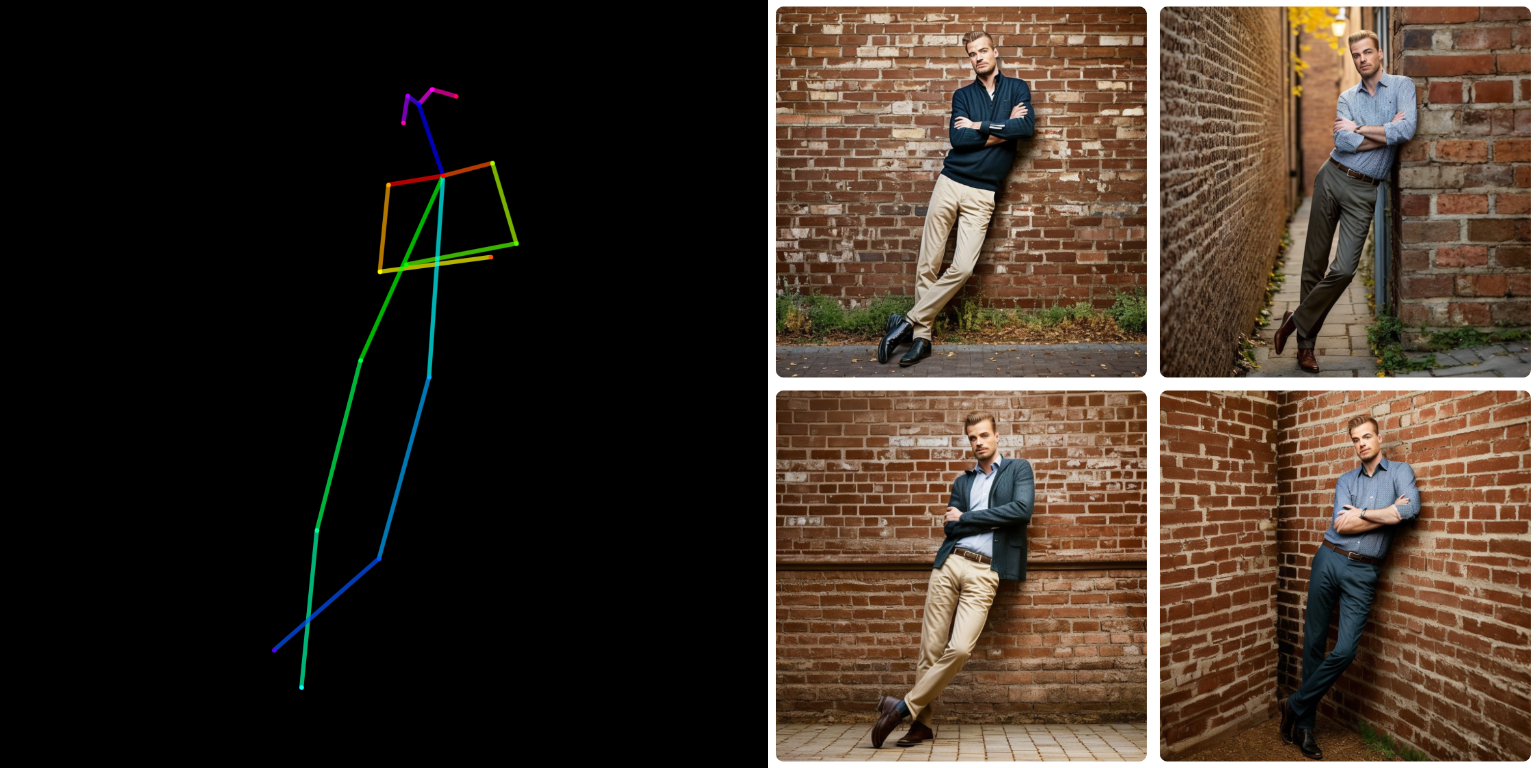

Für Körperhaltungen: OpenPose

Um der KI konkrete Posen oder Körperhaltungen vorzugeben, kann man OpenPose verwenden. OpenPose sieht auf den ersten Blick wie ein einfaches Strichmännchen aus, hat aber einige Tricks eingebaut, um bspw. die Körperhälften oder die Blickrichtung kontrollieren zu können.

Ein Beispiel zeigt, was mit ControlNet und OpenPose möglich ist. Alleine durch die Angabe der Pose steht der Mann im KI-Bild immer an der gleichen Stelle, hat die Beine übereinander geschlagen und die Arme verschränkt. Ein sehr konsistentes und verlässliches Ergebnis.

Die OpenPose-Posen für ControlNet kann man entweder selbst erstellen oder auf Datenbanken wie unter OpenPoses.com zurückgreifen.

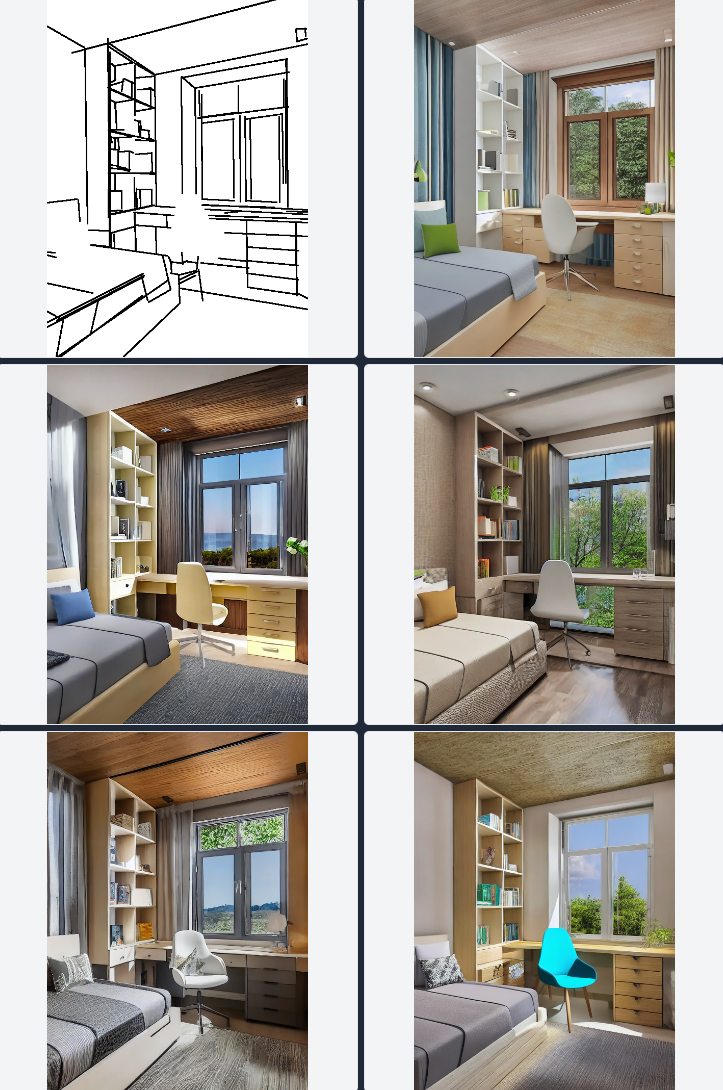

Für Räume und Objekte: M-LSD-Linien

Wenn man mit Räumen, Objekten oder Inneneinrichtungen experimentieren möchte, bietet sich dafür M-LSD an. M-LSD steht für „Multiscale Line Segment Detector“ und sieht aus wie eine einfache Strichzeichnung von einer Szene.

Diese Strichzeichnungen lassen sich entweder manuell anfertigen oder auch aus bestehenden Fotos generieren lassen. Anschließend kann man sie beim nächsten KI-Foto einsetzen, um eine konkrete Szene darzustellen.

Wie wendet man das ControlNet an?

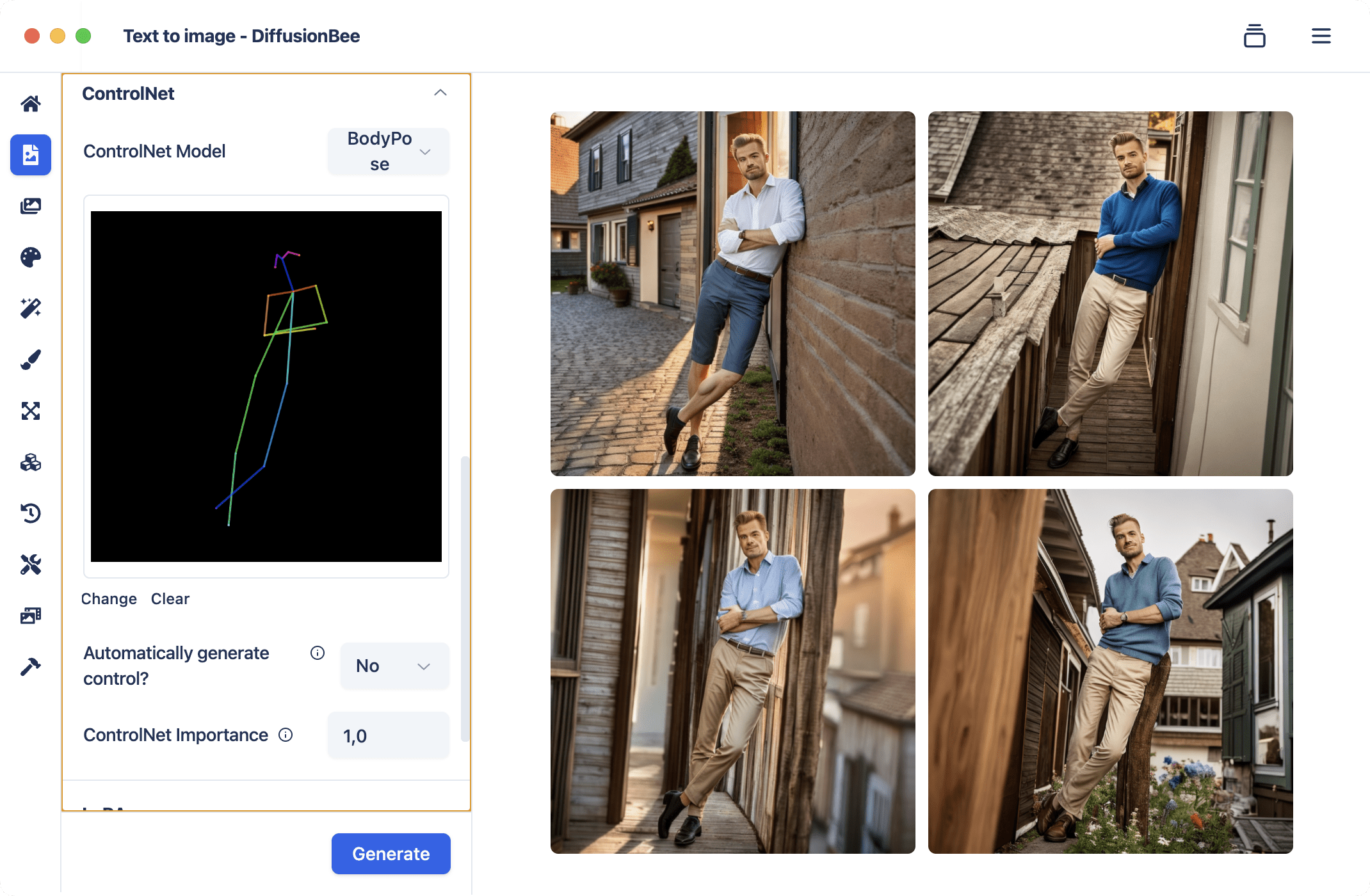

ControlNet wird aktuell nicht von Midjourney oder Dall-E unterstützt, allerdings vom Open-Source-Konkurrenten Stable Diffusion. Man kann ControlNet in allen gängigen Apps für Stable Diffusion verwenden, so unter anderem in Diffusion Bee oder Automatic1111.

Die Apps für Stable Diffusion haben unterschiedlich steile Lernkurven, am benutzerfreundlichsten ist aus meiner Sicht die App Diffusion Bee. Diffusion Bee liegt in der Benutzerfreundlichkeit zwischen Dall-E und Midjourney – wer mit Discord gut zurechtkommt, sollte das mit Diffusion Bee also auch schaffen.

In Diffusion Bee gibt es im Bereich „Text to image“ ein Modul für ControlNet, wo man die einzelnen Modelle anwählen kann. Hier kann man einfach per Drag&Drop anschließend noch das Kontroll-Bild mit OpenPose oder M-LSD hinzufügen und dann wie gewohnt per Prompt Bilder erstellen.

Quellen:

Schreibe einen Kommentar